J’avais oublié de le mentionner… ce blog est parti en vacances. Reprise des posts dans la semaine du 23 juillet. Bon été à tous.

J’avais oublié de le mentionner… ce blog est parti en vacances. Reprise des posts dans la semaine du 23 juillet. Bon été à tous.

Il y a un domaine dont on parle peu, mais qui finalement est aussi important que la vision artificielle ou la robotique : il s’agit du son. La recherche et l’innovation en acoustique sont en effet au cœur des problématiques de défense et de sécurité, comme en témoignent les récentes « attaques » subies par des diplomates américains en Chine et à Cuba. On se rappelle que douze diplomates américains de l’ambassade de La Havane à Cuba ainsi que deux employés du consulat américain de Canton, en Chine, ont présenté sans raison apparente des symptômes similaires à ceux d’une commotion cérébrale, ainsi qu’une surdité subite. A tel point que l’on a parlé « d’attaques sonores » menées contre les diplomates.

Si l’on pense qu’en définitive, de telles attaques sont en réalité le résultat d’interférences entre différents systèmes d’écoute et de transmission par ultrasons, il n’en est pas moins vrai que le son peut, en soi, jouer le rôle d’une arme. De telles armes « soniques », il y en a de plusieurs types. En premier lieu, celles qui utilisent les fréquences audibles par l’oreille humaine (entre 20 Hertz et 20 000 Hertz). De telles armes peuvent être utilisées par exemple comme outils non létaux pour dissiper une foule hostile – j’avais écrit sur ce sujet il y a quelques temps dans cet article.

C’est par exemple le cas du LRAD-100X (l’acronyme correspond à Long Range Acoustic Device) qui utilise un dispositif de transduction piézoélectrique afin de créer un signal sonore concentré et amplifié, capable de calmer même l’individu le plus agressif en focalisant sur lui une onde sonore capable d’atteindre les 120dB (ou même plus – le souci étant qu’à 160 dB, vos tympans explosent).

Les individus qui ont subi une attaque de LRAD mentionnent des symptômes insupportables (le sentiment que les sinus s’enflamment, un saignement des oreilles, une migraine tenace, et même la paralysie et l’insensibilité des parties du corps exposées au signal).

Voici une vidéo déjà ancienne, mais qui illustre bien l’utilisation du LRAD :

En mode infrasonique (en-dessous de 20 Hertz), le principe est le même, mais les effets sont plus… dérangeant puisqu’ils vont du sentiment de coup de poing dans le ventre, au sentiment de nausées et de migraines et jusqu’à… la libération involontaire du contenu de vos intestins (!).

Si l’on s’intéresse à l’autre extrémité du spectre, les ultrasons, les choses sont différentes. Car l’effet des ultrasons sur le corps ne se limite pas à l’audition. En premier lieu, ils ont tendance à chauffer le corps à la manière d’un four à micro-ondes, ce qui peut causer des dommages importants à nombre de cellules. Mais cela se combine à un autre phénomène, comparable à ce qu’il se passe dans le monde sous-marin : la cavitation. Lorsqu’une onde ultrasonique traverse le corps, elle peut générer une cavitation d’autant plus importante que l’onde est forte, ce qui génère la formation de bulles dans le corps, par exemple dans le liquide de l’oreille interne.

Toutefois, les ultrasons perdent rapidement de leur puissance avec la distance, ce qui les rends inadaptés à un emploi opérationnel, à moins de combiner plusieurs faisceaux. C’est d’ailleurs ce qui a pu se produire, de manière involontaire, pour les malheureux diplomates, pris dans des zones d’interférences entre plusieurs faisceaux ultrasoniques équipant des matériels d’écoute. C’est en tout cas la théorie qui prédomine aujourd’hui pour expliquer les prétendues attaques.

Innover dans le domaine sonore, c’est aussi essayer de capturer au mieux le son à des fins d’écoute ou d’espionnage. De nombreux dispositifs existent, et permettent par exemple « d’arroser » le visage d’une personne par des ultrasons, lesquels vont se réfléchir et être capturés ensuite par un dispositif audio classique. A la manière d’un radar, cette réflexion varie en fonction par exemple des mouvements de la bouche, ce qui permet ensuite de reconstituer la voix, en particulier dans des environnements bruités. On peut par exemple mentionner le système SAVAD pour « Super-Audible Voice Activity Detection » qui fonctionne sur ce principe.

Dans ce domaine, l’intelligence artificielle (oui, encore elle) peut venir à la rescousse de l’espion. Tout d’abord en gommant les bruits parasites de fond. La revue Science vient en effet de publier un article dans lequel un système d’intelligence artificielle apprend à distinguer une voix en se guidant sur les mouvements des lèvres et sur l’analyse des différents sons. La combinaison « analyse des sons » et « analyse des indices visuels » semble se révéler bien plus efficace que l’analyse sonore seule. Pour ceux que cela intéresse, le système sera présenté au prochain SIGGRAPH.

Un autre usage de l’IA consiste directement à lire sur les lèvres. On rappelle en particulier que DeepMind, l’IA développée par Google, a développé il y a quelques temps une application de lecture sur les lèvres, entraînée à partir de 5.000 heures de programmes télévisés de la BBC.

Le système est parvenu à un taux de réussite de 46,8 %, un chiffre très impressionnant si on le compare à la performance d’un expert humain entraîné (entre 12 et 20% de réussite). En particulier, le système semble plus robuste aux homophones (ver, verre, vert…), et peut consolider son analyse en généralisant la détection à partir de l’observation de plusieurs orateurs. De là à imaginer une IA observant à distance les lèvres pour capturer et reconstituer la parole, il n’y a qu’un pas; guerre du son, intelligence artificielle, armes infrasoniques… les meilleurs auteurs de science-fiction n’ont qu’à bien se tenir.

Vous l’avez remarqué, ce blog a ralenti – rien d’inquiétant, c’est la préparation et la tenue du salon Eurosatory 2018 qui m’a obligé à lever le pied. Je vais donc repartir du même (pied) dans un ou deux jours, une fois remis de ces dernières semaines assez éprouvantes.

Pour me faire pardonner, voici un article que j’ai commis sur DIUx, dans la revue « Défense et Industries » de la FRS (Fondation pour la Recherche Stratégique). Pour mémoire, DIUx est un acronyme qui correspond à « Defense Innovation Unit eXperimental », et qui désigne un laboratoire d’innovation créé par la défense américaine au sein de la Silicon Valley afin de capturer l’innovation du monde civil.

Pour lire l’article, c’est ici.

J’en profite pour vous signaler que j’interviendrai la semaine prochaine, lors du Paris Air Forum 2018 organisé par La Tribune le 21 juin, au sein d’une table ronde intitulée « IA: la guerre du futur est déjà sur les théâtres d’opérations ». A très bientôt.

Et une nouvelle édition pour le Hackaton Marine Nationale – THALES – Ecole 42, notamment organisé avec le concours de votre serviteur lorsqu’il porte l’uniforme. La soirée officielle de lancement a lieu ce soir à l’Ecole 42, avec un sujet particulièrement ouvert, ci-dessous:

« Les usagers de la mer sont nombreux, variés, en mouvement permanent : pêcheurs, plaisanciers, armateurs, militaires, scientifiques… tous ont de la mer une pratique et une culture. Mais comment partage-t-on la mer ? Comment collabore-t-on en mer ? à l’heure du numérique, de l’échange ou de la mise en commun des données et de l’exploitation de métadonnées, de nouvelles opportunités s’offrent à nous tous.

Le Hackathon Marine 2018 – 2ème édition du partenariat entre la Marine nationale, Thales, 42 et le programme MATRICE – aura pour ambition de répondre à ces défis. Le but : esquisser « un Cloud de la mer ». Favoriser les collaborations comme anticiper les menaces et les risques, c’est stratégique ! » Il s’agit donc de développer un outil collaboratif de partage de situation maritime entre tous les usagers de la mer afin d’enrichir les solutions de navigation.

Le Hackaton aura lieu à Paris du 5 au 7 juin 2018, au sein de l’Ecole 42… J’en profite pour rappeler ce qu’est un Hackaton : Le terme « Hackathon » provient de la contraction en « hacker » et « marathon ». Il s’agit donc d’un marathon de hackers (je rappelle que hacker ne signifie pas pirate), soit une rencontre de développeurs, informaticiens, graphistes, étudiants volontaires qui se réunissent pour faire de la programmation informatique collaborative, sur plusieurs jours. Il s’agit d’un processus créatif fréquemment utilisé dans le domaine de l’innovation numérique.

Rendez-vous donc à la fin de cette semaine pour connaître les gagnants de cette édition.

J’ai des marottes, et le biomimétisme en est une. Petit rappel : le biomimétisme, c’est notamment le fait de s’inspirer de la nature afin de concevoir des solutions innovantes, adaptées et efficaces en ingénierie. J’avais par exemple écrit cet article sur la squille, une super-crevette capable de générer de la super-cavitation, et dotée d’une hyper-sensibilité visuelle impressionnante la rendant capable de distinguer et de cibler des différences infimes dans l’infrarouge ou l’ultraviolet.

Après les essaims bioinspirés, les robots raies-manta, les supercrevettes ou la gourde inspirée du scarabée de Namibie, voici donc le camouflage inspiré des céphalopodes. J’avais également écrit sur le sujet il y a quelques temps (voir cet article ) – l’université de Cornell avait en effet développé une « peau électronique » capable de changer de couleur et de sentir les variations de pression, à base d’un « sandwich » de gel de silicone, emprisonnant deux électrodes extensibles et transparentes, et une couche de phosphore électroluminescent capable d’émettre une lumière colorée. Le but ? Développer une peau de camouflage pour un robot; mais la technologie était néanmoins quelque peu balbutiante.

Une nouvelle recherche publiée dans la revue Advanced Optical Materials et intitulée « Natural Light-Scattering Nanoparticles Enable Visible through Short-Wave Infrared Color Modulation. » (ouf) relance le sujet. Il s’agit de travaux réalisés par l’université de Northearstern, en collaboration avec le Natick Soldier Research, Development and Engineering Center.

La recherche porte sur les chromatophores, ces organes spécialisés neuromusculaires présents chez les seiches ou les poulpes, et contenant des pigments dont ils gèrent la répartition. Cela confère aux bestioles des capacités incroyables de camouflage dynamique – voir la vidéo ci-dessous.

Ce n’est d’ailleurs pas l’apanage unique des céphalopodes – on trouve des chromatophores chez certains amphibiens, reptiles, crustacés, ou même poissons. Ces chromatophores sont tapissés sur une couche d’autres cellules : des iridophores qui jouent le rôle de miroirs en reflétant la lumière visible et en contrôlant sa couleur.

Dans ces nouveaux travaux, le Pr Leila Deravi et son équipe ont analysé les particules de pigments extraites des céphalopodes (il s’agit de particules extrêmement petites, d’un diamètre moyen de 500nm). Ces particules forment des films à la surface de la peau (avec une épaisseur d’environ un micromètre, soit deux particules) capables de diffuser la lumière, non seulement dans le spectre visible mais également dans le proche infrarouge. Les chercheurs ont réussi à répliquer ces nanofilms, afin d’incorporer de telles particules dans des textiles, et en particulier dans des treillis ou combinaisons de camouflage.

Cette capacité de diffusion augmente lorsque l’on réplique les iridophores, c’est-à-dire lorsque le film est placé sur une couche qui joue le rôle de miroir. Le résultat (et donc l’intérêt pour la défense) est double : (a) permettre de contrôler la couleur et la diffusion de la lumière afin de répliquer des couleurs et intensités proches de l’environnement du combattant – ce que l’on appelle un textile fonctionnalisé et (b) permettre la constitution de véritables « nano-panneaux solaires » capables d’absorber de manière optimale la lumière pour permettre le stockage d’énergie.

Les chercheurs ont ainsi pu fabriquer des fibres de tels films inspirés des chromatophores. Une recherche de pointe, sur le point d’aboutir au développement de textiles comparable à la peau des céphalopodes, et une avancée significative en comparaison de tous les travaux précédents sur le sujet.

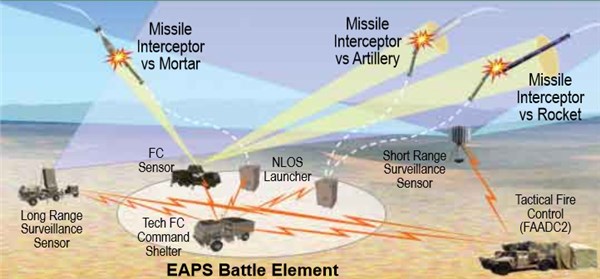

Bien que le projet soit engagé depuis 2012, c’est ce mois-ci, lors de la conférence FIRES de Fort Sill (USA), qui permet chaque année aux industriels de dévoiler leurs dernières innovations en termes de technologie de défense (ci-dessous), que Lockheed Martin a fait le « buzz ». La firme américaine a en effet, et pour la première fois, dévoilé des détails et caractéristiques techniques sur son missile miniature « Hit-To-Kill » (MHTK).

Il s’agit d’un nouveau type de missile miniature, permettant, sur le même principe que le système « Iron Dome » israélien, de constituer une bulle de protection autour d’installations sensibles, ou de troupes déployées.

La bestiole est très, très compacte ; en gros, la taille d’un parapluie : 71cm de long dans sa dernière version (contre 68cm initialement), un diamètre de 4cm, et un poids d’environ 2,2 kg. Cela, en soi, c’est une innovation. Car le missile MHTK embarque un radar miniaturisé à antenne active, un système de propulsion et son carburant, le système de contrôle, et bien évidemment une charge utile (en l’espèce, de la même manière qu’un obus flèche, c’est l’énergie cinétique qui provoque l’effet militaire, sans besoin d’une charge explosive). Le système de tracking est une antenne AESA (active electronically-scanned array) qui procure un champ de balayage de 45° en élévation, avec un angle de 90°. Pour mémoire, un radar AESA remplace l’antenne mécanique mobile d’un radar classique par un ensemble fixe composé de plusieurs modules émetteur/récepteur. Chacun de ces modules est commandé individuellement, ce qui permet d’orienter le faisceau dans la direction souhaitée.

L’emploi privilégié du MHTK est la protection d’installation contre des attaques de type roquettes, missiles ou drones. Différents radars couvrant la zone ont fonction de détecter la menace. Une fois celle-ci identifiée, le MHTK est lancé, et va se diriger vers les coordonnées signalées par le radar, avant d’engager une phase de recherche autonome de sa cible en analysant notamment sa vitesse d’approche. L’interception est directe (« hit to kill ») et permet d’éviter les dégâts collatéraux que l’on peut redouter si l’on emploie une charge explosive au lieu d’une charge cinétique.

L’objectif est de pouvoir lancer le MHTK à partir de plateformes mobiles (camions lanceurs) ou même d’employer des systèmes de lancement verticaux, permettant d’embarquer une trentaine de missiles, qui ensuite trouveront d’eux-mêmes leur cible (plusieurs versions du MHTK existent, actives ou semi-actives, mais elles possèdent toute la même configuration). Lockheed Martin cherche ainsi à imposer le choix du MHTK comme le système retenu dans le cadre du programme Indirect Fire Protection Capability de l’US Army.

Mais comment Lockheed Martin a-t-il réussi à miniaturiser un tel système (gage notamment de sa manœuvrabilité une fois dans les airs, sachant qu’il doit intercepter des cibles elles-mêmes très manœuvrantes) ? La réponse : en s’inspirant de technologies civiles !

Son système de tracking utilise ainsi des composants issus de l’imagerie médicale (en particulier en convertissant les radiofréquences en signaux lumineux – pour le coup, c’est le niveau maximal d’information fourni par Lockheed Martin !). Ce faisant, le système gagne en compacité. Les ingénieurs se sont également inspirés de l’industrie des smartphones afin d’en dériver des modules et en particulier d’en exploiter une caractéristique très intéressante : dans un smartphone, l’électronique est conçue de telle façon que les composants n’interfèrent pas entre eux alors qu’ils cohabitent dans un facteur de forme très compact. Une caractéristique évidemment très utile au domaine militaire.

Ce « baby missile » comme la presse le surnomme déjà est donc l’illustration parfaite des fertilisations croisées entre le monde civil, grand public, et l’innovation technologique de défense. De plus, l’utilisation de technologies dites CE pour « Consumer Electronics » permet de garantir une certaine robustesse. Un smartphone doit pouvoir tomber, encaisser des chocs, des variations de température, sans pour autant cesser de fonctionner. Finalement, le monde civil est parfois plus exigeant en termes de robustesse que le monde militaire.

Le missile MHTK – s’il remporte la compétition – devrait être mis en service d’ici 2022.

Le titre peut faire sourire, mais la nouvelle est bien sérieuse. C’est la société turque Albayraklar (son site web n’est malheureusement pas traduit en anglais et je ne parle pas le turc donc je ne peux pas vous en dire grand chose) qui a dévoilé une vidéo montrant un essaim de drones sous-marins comparables à des raies manta, évoluant sous l’eau et approchant d’autres poissons, jusqu’au moment où ils détectent la présence d’un porte-avions, se faufilent sous sa coque et font détoner leurs charges explosives. Voici le film (ci-dessous).

Science-fiction ? Invention délirante. Eh bien en fait non. Au-delà de l’aspect un peu kitsch de la vidéo, il s’agit bien d’un projet sérieux. Car l’intérêt du biomimétisme, et dans ce cas particulier d’imiter la raie, c’est de s’inspirer des caractéristiques uniques de sa propulsion. A la différence des requins ou autres poissons osseux, la raie se propulse par un mouvement unique de ses ailes, qui lui confère plusieurs capacités. En premier lieu, la stabilité sans avoir besoin de propulseur, ni de stabilisateurs. Et donc, par conséquence, une grande discrétion sous l’eau : pas de bruit, pas de signature sonar. Ce mode de propulsion par déformation et ondulation des ailes (à l’aide de trois moteurs intégrés dans le robot) lui confère également une grande endurance (12h à une vitesse de 5,5 nœuds). On trouve également deux caméras lui permettant de transmettre une image (voire, à terme, de faire de la reconnaissance automatique).

Le robot – de son petit nom Wattozz (a priori une adaptation du mot turc pour « raie ») possède une structure interne en titane et aluminium ; il est recouvert d’une couche de matériau absorbant afin de rendre le métal invisible au sonar, et dispose d’ailerons en silicone. Il comporte aussi des petits électro-aimants qui lui permettent, une fois sa cible repérée, de s’y fixer. Il peut également se poser sur le fond sous-marin, en attente de sa cible. Sa taille n’est pas précisée, mais si l’on en croit la vidéo, il fonctionne par essaim, ce qui signifie qu’il n’est pas suffisamment grand pour infliger les dommages nécessaire à sa cible, à lui seul.

Comment est-il contrôlé ? C’est une bonne question à laquelle je ne suis pas parvenu à trouver une réponse convaincante. On parle d’ondes sonores sous-marines cryptées, j’imagine qu’il s’agit là d’une formulation pour le canal acoustique sous-marin (ASM) – un mode de communication connu, efficace mais complexe car le milieu sous-marin n’est pas isocélère, et que la propagation du son varie en fonction de la température, la pression hydrostatique ou même la salinité. Cela semble néanmoins être une bonne solution, mais qui requiert un compromis entre robustesse du signal et efficacité du système de transmission. Cependant, je ne suis pas un spécialiste.

Ce n’est d’ailleurs pas la seule initiative de ce genre. On peut par exemple citer le robot Manta de la société Evologic, ou le MantaDroid de la NUSde Singapour (ci-dessous).

Mais c’est en tout cas le seul projet biomimétique militaire de ce type. Il est d’ailleurs si bien intégré dans son environnement biologique, que pour lui éviter de se faire dévorer par des prédateurs, la société Albayraklar a décidé de doter le Wattozz d’un système d’autoprotection par ultrason afin de décourager tout requin qui serait un peu trop gourmand.

Au-delà de l’aspect original, il s’agit bien de biomimétisme appliqué au monde de la défense. Car la propulsion de la raie est bien plus efficace – en termes de vitesse, de discrétion, d’énergie – que celle conférée par une hélice classique.

La nature est donc une superbe source d’inspiration pour les ingénieurs – ainsi, la marine américaine s’est inspirée des nageoires pectorales des poissons pour développer des robots sous-marins coopératifs (« finned bioinspired unmanned underwater vehicles ») en vue de conduire des missions d’exploration en zone littorale ou au plus près des côtes.

Dans de tels environnements, la turbidité de l’eau, la présence de nombreux courants et d’obstacles ne permettent pas l’emploi de drones sous-marins classiques. En ce cas, la propulsion par nageoires pectorales à très basse vitesse permet une manœuvrabilité inaccessible par des techniques conventionnelles. L’US Navy a ainsi développé WANDA (oui, c’est un acronyme pour Wrasse-inspired Agile Near-shore Deformable-fin Automaton !!!), un drone sous-marin portable capable de se déplacer à 2 nœuds, ou de résister à des courants de 2 nœuds.

On n’arrête pas le progrès, surtout quand il s’inspire de 4 milliards d’années d’ingénierie appliquée, l’Evolution.

Oui, le sujet de ce post est assez énigmatique. Depuis quelques semaines, je multiplie les articles sur l’IA et ses applications militaires ou de sécurité, pour coller à l’actualité. Aujourd’hui, voici deux exemples assez concrets (voire un peu inquiétants) qui touchent au « deep learning » et dont les applications sont véritablement impressionnantes.

Reconnaître des visages dans le noir

La reconnaissance faciale est l’une des technologies les plus connues et les plus immédiates du « deep learning ». Au passage, je me permets un petit rappel, tout le monde n’étant pas spécialiste de l’intelligence artificielle. Le deep learning est un sous-ensemble des techniques d’apprentissage machine à base de réseaux de neurones – le principe est de décomposer de manière hiérarchique le contenu d’une donnée complexe comme de la voix ou une image pour la classifier ensuite.

Le terme de deep learning a été inventé par Yann le Cun, actuel directeur du laboratoire d’IA de Facebook en France, pour « booster » sa recherche de fonds dans le domaine des réseaux de neurones qui était alors tombé en déshérence. Au-delà, il regroupe aujourd’hui nombre de techniques d’apprentissage à base de réseaux de neurones profonds, qui ne s’appuient pas sur des règles établies par avance. C’est, au passage, un problème : comme le souligne le rapport Villani, le deep learning est une « boite noire », car on se trouve dans l’incapacité de décrire de façon intelligible le résultat produit sur chaque nouveau cas, et en particulier à pointer les caractéristiques les plus importantes du cas en question ayant conduit au résultat produit.

En l’occurrence, ces techniques sont très efficaces par exemple pour reconnaître des visages : à la fois en raison de la disponibilité d’images pour réaliser l’apprentissage, et de par le développement considérable des capacités de calcul (GPGPU par exemple), des sous-types de réseaux de neurones profonds comme les DCN (deep convolutional neural networks – je ne rentre pas dans le détail) sont capables de reconnaître des visages avec des performances proches de l’humain (voir par exemple le projet DeepFace).

Mais cela, dans le spectre visible. Dans l’obscurité, on traite les images infrarouge, et cela pose un problème car les taux de reconnaissance chutent alors de façon drastique. La nuit, ou même dans certains cas où l’illumination n’est pas suffisante, les techniques de reconnaissance biométrique par réseaux de neurones ne peuvent plus fonctionner, sauf à utiliser une lampe torche, ce qui manque évidemment d’une certaine discrétion. La raison est simple : les visages à reconnaître en infrarouge doivent être combinés à une image provenant d’une base de données qui, elle, a été créée en lumière visible. Comme on le voit sur l’image ci-dessous, la comparaison est difficile.

Pour surmonter ce problème, des chercheurs du ARL (US Army Research Laboratory) et de la firme Booz Allen Hamilton ont imaginé utiliser les réseaux de neurones afin de synthétiser à partir d’une image infrarouge, un visage en lumière visible qui, lui, pourra être comparé aux bases de données normales. Pour ce faire, ils utilisent une double technique : une régression non linéaire à l’aide de réseaux DCN pour extraire des caractéristiques de l’image thermique et construire une première représentation du visage, puis une synthèse et une optimisation des gradients permettant de projeter cette représentation dans le domaine visible – voir le processus ci-dessous et se reporter à l’article suivant qui donne tous les détails .

Le résultat est spectaculaire : l’image synthétisée correspondant au visage non visible en thermique plus haut, est cette fois-ci beaucoup plus proche de sa représentation dans la base de données, ce qui permet une identification par des techniques de biométrie elles-mêmes fondées sur l’utilisation de réseaux de neurones.

Et cela fonctionne très bien: lors de la conférence, les chercheurs ont ainsi utilisé une caméra thermique FLIR Boson 320 avec un portable permettant de faire tourner la démonstration en quasi temps-réel.

Mais les apports du deep learning ne s’arrêtent pas là…

Simuler un visage… et l’animer

Regardez cette vidéo. Non mais regardez-la vraiment….et jusqu’au bout.

Ce n’est donc pas Barack Obama qui parle, mais une combinaison d’une captation de son visage et d’un algorithme permettant de remplacer le mouvement de ses lèvres par un mouvement synthétique. Le résultat : on peut lui faire dire n’importe quoi, et je vous défie de le détecter. Impressionnant, et effrayant. Merci à mon fils qui m’a permis d’identifier et d’étudier cette vidéo.

C’est ce que l’on appelle un « deep fake » : un montage extrêmement réaliste permettant de simuler de manière photoréaliste, et grâce à l’IA, une vidéo plus vraie que nature. L’origine de ces fausses vidéos ? Un développeur opérant sur Reddit, sous le pseudonyme de « deepfakes », qui a adapté des techniques de deep learning en source ouverte, afin de substituer un visage de synthèse à un visage réel. Depuis (et après pas mal d’applications dans la pornographie, je vous laisse imaginer) la technique est devenue accessible à tous. L’exemple de Barack Obama montre ce qui est possible de faire, lorsque l’on est un tant soit peu professionnel.

L’idée est de rassembler le plus d’images possibles de la cible (c’est pourquoi généralement les deep fakes s’attaquent à des personnalités publiques, dont les images circulent en grand nombre sur Internet). L’imposture consiste ensuite à apprendre (par deep learning) les traits caractéristiques de la cible – en l’occurrence le mouvement des lèvres – et à les remplacer par une image de synthèse commandée en temps réel par le « marionnettiste » (un individu dont on capte les mouvements des lèvres qui sont ensuite projetés sur les mouvements des lèvres de la cible).

Le souci c’est que l’on croit tout ce qui est sur Internet (la preuve dans mon article du 1er avril largement relayé, ce qui me fait encore rire) et que l’on croit encore plus ce que l’on voit. Ces techniques, qui relevaient il y a un an du projet scientifique, sont aujourd’hui démocratisées et accessibles. Le diagnostic est donc immédiat et fait peur : on ne peut plus croire ce que l’on voit. Reste donc à imaginer des algorithmes permettant, en identifiant les subtiles différences, à détecter l’imposture, et à discriminer le « deep fake » du vrai. Mais si cela reste possible pour les spécialistes et les scientifiques, il sera toujours facile pour un grand nombre d’entre nous de prendre l’image pour la réalité. Une nouvelle ère s’annonce donc, dans le domaine de la propagande et des manipulations psychologiques, une ère dans laquelle la prudence voire la méfiance s’imposent. Et cela, ce n’est pas drôle…

Cette semaine, rencontre avec l’un de mes amis, David Menga, que certains d’entre vous connaissent sûrement. David est expert dans l’Internet des Objets, l’IA et blockchain appliqués à la smart home, au smart building et à la smart grid.

Dans la vie, il est chercheur à l’EDF Lab et coordinateur technologique du pôle de compétitivité Normand TES (Transactions Electroniques Sécurisées). Il a co-édité avec Nobuo Saito, professeur émérite de l’Université Keio au Japon, un livre intitulé « Ecological Design of Smart Home Networks, Social Impact and Sustainability ». Bref, un chercheur, un curieux insatiable, et un homme de vision notamment dans le domaine de l’Intelligence Artificielle dont nous allons bien évidemment parler. Petite interview entre amis:

David, tu es chercheur à l’EDF Lab. Bon, aujourd’hui toutes les institutions et tous les grands industriels ont leur lab. Alors c’est quoi, l’EDF Lab – un lab de plus ou un précurseur?

EDFlab est le plus grand centre industriel de recherche et formation en Europe. Son rôle est de préparer l’avenir du groupe EDF, à la croisée des mutations numériques et énergétiques.

Quelles sont tes thématiques et sujets de prédilection ?

Je travaille beaucoup sur les nouveaux relais de croissance pour la branche commerce d’EDF, comment aller au-delà de la vente simple d’électrons et offrir des services à valeur ajoutée à nos clients. Cela signifie trouver des positionnements pertinents pour EDF dans un monde numérique massivement connecté et en pleine transition énergétique vers des systèmes de production décentralisées et renouvelables. Je travaille concrètement sur la digitalisation des tableaux électriques, la transformation des supports d’éclairage en plateformes de services, et la mise en œuvre de coachs énergétiques à travers des intelligences artificielles capables de raisonner et de dialoguer avec un utilisateur en argumentant.

Alors pour les lecteurs de ce blog, tout ceci ne parle pas encore d’innovation de défense, mais bien évidemment, les technologies sont connexes – tu as d’ailleurs participé au projet SOFLAB organisé par le Cercle de l’Arbalète. Allons donc dans le dur – dans ce blog, j’ai beaucoup parlé à la fois des « games changers » comme l’hypervélocité, l’IA et le big data, le quantique (au sens large)… et des pays qui se dotent massivement de moyens pour participer à cette course à la technologie. En particulier la Chine. Quelle est ta perception de la « géostratégie » des ruptures technologiques dans le domaine ? Et d’ailleurs, vois tu d’autres ruptures que celles que j’ai citées ?

Je vois particulièrement des ruptures dans l’univers de la biologie et de la chimie quantique.

J’entrevois l’évolution des usines chimiques actuelles en usines bactériennes programmables capables de produire à la demande les matériaux indispensables à notre civilisation moderne, offrant les mêmes qualités d’usage et biodégradables.

J’entrevois la possibilité grâce au ordinateurs quantiques, de fabriquer à la demande de nouveaux matériaux répondant à des cahiers des charges précis. Ce serait une évolution majeure de l’imprimante 3D.

Plus généralement, je pense que nous allons basculer dans l’ère post silicium, celle du carbone dont on redécouvrira les bienfaits une fois capturé et domestiqué à des coûts acceptables. En particulier, je pense que l’électronique au graphène et aux nanotubes de carbone va se développer dans la prochaine décennie.

La conséquence de tous ces progrès sera une révolution dans l’énergie, la manière dont on la produit (panneaux solaires au rendements proches de 50 % , turbines au CO2 , éoliennes silencieuses et performantes ) , la manière dont on la distribue ( câbles supraconducteurs, réseau intelligent tolérant aux pannes, courant continu ) et enfin la manière dont on la consomme. Les réseaux énergie sans fil vont se développer avec la mobilité électrique.

La santé est aussi un secteur à fort potentiel d’évolution, avec les progrès de la médecine personnalisée, prédictive, préventive et régénérative. La génomique et l’épigénétique sont au cœur de cette révolution. Enfin, j’entrevois de nouveaux modèles économiques où le consommateur est au centre de la proposition de valeur grâce à la blockchain.

Pour l’instant, toutes ces transformations sont tirées par la Chine et les Etats Unis. L’Europe place ses efforts dans la règlementation et l’éthique, certes nécessaires mais non producteurs de richesses.

De la même manière, on assiste à la consolidation des acteurs privés de la technologie – les GAFA (Google, Apple, Facebook, Amazon) mais pas seulement. Quelle est ta vision de l’évolution du paysage, et qu’anticipes-tu comme impact dans le domaine de la défense et de la sécurité ?

Je pense que les grandes entreprises GAFA et BATX (note : BATX = Baidu, Alibaba, Tencent et Xiaomi) vont prendre de plus d’importance dans les états où ils opèrent. L’affaire Cambridge Analytica montre les dérives d’un système sans contrôle, avec la manipulation à large échelle de l’opinion, ce qui pose des problèmes de sécurité nationale.

De plus, leur maîtrise de l’IA les rendra indispensables pour construire des systèmes de défense efficaces, comme le montre l’utilisation de l’outil Tensorflow de Google par les militaires américains. (Note: voir mon dernier article sur le projet MAVEN)

Parlons d’IA. La mission Villani vient de s’achever et le président a présenté le rapport il y a deux semaines lors d’une « grande messe de l’IA » au Collège de France (une première dans le domaine). En premier lieu, que penses-tu de ce rapport et des préconisations qui y sont présentées ?

Le rapport Villani pose un bon diagnostic sur l’importance de l’IA dans la société, mais apporte des réponses trop sectorielles, trop limitées. Plus de recherche en deep learning, plus de données en mode ouvert, plus de puissance de calcul disponible pour les scientifiques, cela ne constitue pas une réponse industrielle au retard colossal de la France en la matière. Cela renforce la vassalisation de notre recherche aux intérêts des géants de l’Internet, GAFA ou BATX.

D’ailleurs, le jour même, Google comme Samsung annonçaient la création d’un centre de recherche IA en France. Matière grise en France, subventionnée par le contribuable et profits à l’étranger, renforçant notre déficit commercial.

En un mot, le rapport Villani est un « plan calcul du deep learning ». Nous connaissons tous la suite.

C’est sévère. Alors pour rester compétitive dans ce domaine, que doit faire la France, notamment dans le domaine du hardware (et de l’open hardware) ?

La France doit investir massivement dans l’IA post deep learning, l’IA prévisionnelle, capable de raisonner et de planifier dans un univers incertain, avec des informations parcimonieuses et incomplètes. Une IA capable d’apprendre à partir de ses expériences sensorielles et de ses interactions avec les humains, intégrable dans des systèmes embarqués à basse consommation, autant qu’une lampe LED. Bref, une IA capable de s’adapter à des contextes variables en milieu ouvert.

Cela requiert de nouveaux hardwares à inventer, une nouvelle architecture post Von Neumann, couplant données et traitements et d’immenses facultés de parallélisation des tâches. Et bien sûr , une nouvelle façon de concevoir des algorithmes et de les implémenter. Le cerveau fournit un bon modèle qu’il s’agira de comprendre et de dépasser. L’Open Hardware, comme le RISCV , doit être au cœur de ce programme ambitieux car il ne s’agit pas de réinventer la poudre. Inspirons nous du programme Celerity de la DARPA.

La France doit mettre l’IA au cœur de ses formations qualifiantes, pour habituer les étudiants à mieux collaborer avec elles. Il s’agit d’offrir aux étudiants des « Legos » IA programmables et composables, le tout avec de l’open hardware et de l’open source. Il importe de créer une industrie des machines outils de l’IA, des IAs capables de fabriquer d’autres IAs plus spécialisées à partir de composants open source ou pas.

Pensez à une IA de conception de circuits électroniques comme celle de Thingtype

couplée à une imprimante 3D de PCB comme celle de Nanodimension plus une IA de génération de logiciel. Il s’agit de construire des produits/services intégrant directement de l’IA et répondant à un cahier des charges précis. En un mot, la France doit maîtriser les outils pour bâtir ce que j’appelle « l’atmosphère IA», c’est dire des IAs massivement intégrées dans notre société.

Enfin, Elon Musk a dit « le meilleur moyen de se faire une petite fortune dans le domaine spatial, c’est de commencer avec une grosse ». Si tu avais aujourd’hui de l’argent pour financer des projets innovants, et je parle là du domaine de la défense et de la sécurité au sens large, que penserais tu financer ?

En toute cohérence, j’investirais massivement dans ces fameuses « machines-outils IA » permettant de produire des IA embarquées à vocation militaire, capables de remplir soit des missions de renseignement dans des drones miniatures de type libellule, soit des missions d’attaque en essaims avec des armes infrasoniques.

La voix humaine a cela de spécifique qu’elle est supposée provenir d’un humain. Dit comme cela, ça semble évident, mais si vous regardez par exemple le film « Annihilation » sur Netflix (non je n’ai pas d’actions mais j’aime bien le cinéma), où un redoutable prédateur imite la voix humaine pour attirer ses proies, alors vous comprenez vite le côté légèrement anxiogène d’une voix humaine non humaine (sic). Ci-dessous la bébête, pour info.

Alors imaginez maintenant qu’une voix désincarnée mais manifestement humaine retentit soudainement dans l’espace juste à 30 cm de votre visage… Pas possible?

C’est pourtant ce que le Pentagone est en train de faire en utilisant une technologie peu commune à base de lasers. Jusqu’à maintenant, dans ce blog, nous avions parlé à plusieurs reprises des lasers utilisés comme armes (notamment dans le contexte de l’apparition de missiles hypersoniques trop rapides pour être neutralisés par des armes conventionnelles). Mais les lasers peuvent être utilisés dans de nombreux autres domaines. Ici, il s’agit d’une technique baptisée « Effet Plasma Induit » (Laser Induced Plasma Effect) et met en œuvre deux faisceaux laser.

Le principe repose sur la génération à partir d’un premier laser femtoseconde d’une boule de plasma – en gros, il s’agit de focaliser des impulsions laser sur une région (un point dans l’air) pendant une quinzaine de seconde. L’effet obtenu c’est la génération à partir de molécules de l’air d’un champ électrifié (les électrons étant littéralement arrachés par les impulsions laser).

Cette boule de plasma est très réactive aux radiations électromagnétiques. Lorsque l’on focalise un second laser (cette fois-ci un nanolaser dont les longueurs d’ondes se trouvent dans une fourchette extrêmement étroite) alors la boule de plasma réagit en émettant de la lumière… et du son.

En l’occurrence, la fréquence du son peut être contrôlée de manière à ressembler à la voix humaine. Les chercheurs n’en sont pas encore là : aujourd’hui on obtient un son bizarre, déformé mais dont on perçoit qu’il peut rapidement être intelligible (voir vidéo ci-dessous à regarder avec le son – idéalement un casque).

Ce que les chercheurs confirment d’ailleurs : selon David Law, directeur du laboratoire JNLWD du ministère de la défense américain (JNLWD signifiant Joint Non-Lethal Weapons Program : programme interarmées d’armes non létales), il ne manque que 3 ou 4kHz de plus pour obtenir…un point dans l’air capable d’émettre des paroles intelligibles. Une capacité envisagée dans moins de trois ans.

A quoi cela sert-il ? Imaginez des ennemis ou des populations qui soudainement se trouvent confrontés à une voix venue de nulle part, au-dessus de leur tête, sans enceinte visible… Le but est clairement de faire peur, ou de défendre un point de passage, ou une frontière. D’autant plus que l’arme est puissante : elle peut également générer de la chaleur et donc faire fuir les individus ciblés, ou émettre des sons imitant des coups de feu ou des explosions. La vidéo complète se trouve ci-dessous :

A terme, en utilisant des optiques de grand diamètre, on peut imaginer cibler un point dans l’air à plusieurs dizaines de kilomètres – en utilisant notamment un effet baptisé l’effet Kerr et dont nous avions déjà parlé dans cet article.

On a donc ici une arme non létale, capable de flanquer les chocottes à un combattant, un trafiquant ou un intrus à une trentaine de kilomètres, tout en épargnant les individus qui se trouveraient entre l’émetteur et la cible. D’autant que l’émetteur pourrait être aéroporté sur un hélicoptère, un avion ou un drone. On connaissait l’expression « eye in the sky » – les concepteurs d’opérations psychologiques (psyops) peuvent maintenant envisager l’effet « scary voice in the air ». Nous vivons une époque formidable…