En mars dernier s’est déroulée une expérimentation novatrice (dans son sujet comme dans sa forme) dans le domaine de la robotique terrestre avec le soutien de l’Agence Innovation Défense. Retour sur cette opération et son contexte.

L’armée de Terre emploie déjà fréquemment des robots de petite taille pour la lutte contre les engins explosifs improvisés au sein de l’arme du Génie. Elle ambitionne aujourd’hui de développer un axe robotique plus large au sein des unités SCORPION. Dans le cadre de la feuille de route SCORPION validée par la ministre des Armées en mai 2018, la Direction générale de l’armement (DGA) et l’armée de Terre préparent l’acquisition, cet été, de micro robots de reconnaissance au profit de l’Infanterie et du Génie.

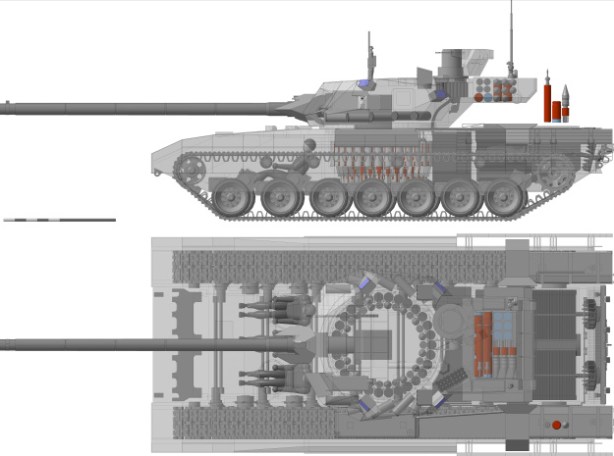

En parallèle, l’État-major de l’armée de Terre (EMAT) et l’Agence de l’innovation de défense (AID) ont réalisé, avec l’appui des experts techniques de la DGA, une expérimentation opérationnelle d’une semaine au Centre d’entraînement en zone urbaine (CENZUB) avec plusieurs robots téléopérés de grande taille (classe 500 kg à 4 tonnes) provenant de quatre industriels: Arquus (robot Dagger), Tecdron (robot Sentinel), Nexter (robot Optio) et Shark Robotic (robot Colossus et mule Barakuda) Il s’agissait, en accomplissant des missions tactiques simples, d’identifier en quoi et comment l’emploi de robots, tels qu’ils sont actuellement, peut influencer la manœuvre tactique. L’expérimentation a d’ores et déjà permis de recueillir de précieux enseignements d’ordres technique, organisationnel et opérationnel. La vidéo ci-dessous présente un résumé de cette opération.

Cette expérimentation est conduite en complément des travaux déjà réalisés par la DGA dans le cadre du démonstrateur FURIOUS ou des études pour le développement de briques technologiques comme l’autonomie de navigation ou la coopération multi-robots. Elle permet notamment d’affiner la réflexion sur les usages des robots téléopérés en conditions réelles et contribue à préparer l’acquisition des robots SCORPION.

L’AID et l’EMAT planifient, d’ores et déjà, de poursuivre leurs expérimentations en projetant en opérations extérieures, dès 2020, quelques robots à vocation transport de charge et observation. L’AID, s’appuyant sur l’Innovation Défense Lab (dont je parlerai bientôt), accompagne l’armée de Terre dans la construction et le financement de ce projet comme dans la préparation des phases ultérieures de cette expérimentation.

Ces études et expérimentations s’inscrivent dans le cadre plus large d’une politique ministérielle d’investissement, portée par la Loi de programmation militaire, au profit de la modernisation des équipements et des innovations technologiques.