Tous ceux qui ont visité le magnifique musée de l’automobile de Turin (que je conseille sans aucune hésitation) se rendront compte que la roue, le pneu, bref, le moyen de se mouvoir pour un véhicule terrestre n’est pas forcément aussi simple qu’il n’y paraît. On y voit une collection fascinante de roues, de pneus, de concepts plus ingénieux les uns que les autres. Comme quoi, rouler, ce n’est pas simple.

En particulier, dans le monde du combat terrestre, se déplacer rapidement peut être une alternative à la course au blindage et à la protection. J’avais d’ailleurs déjà parlé dans ce blog des défis conçus par la DARPA (l’agence américaine pour les projets avancés de recherche en matière de défense). Parmi ceux-ci, le défi GXV-T (Ground X-Vehicle Technology, qui visait il y a quelques temps à inventer un nouveau concept pour le véhicule armé blindé du futur. Plus que le char de l’avenir, l’idée consistait en particulier à lutter contre l’idée que ce véhicule serait plus lourd, plus blindé, plus résistant. Avec un objectif déclaré : réduire le poids du véhicule de moitié, doubler leur vitesse de pointe (donc remplacer la protection par l’agilité et la vitesse), tout en étant capable de se déplacer sur 95% des terrains imaginables.

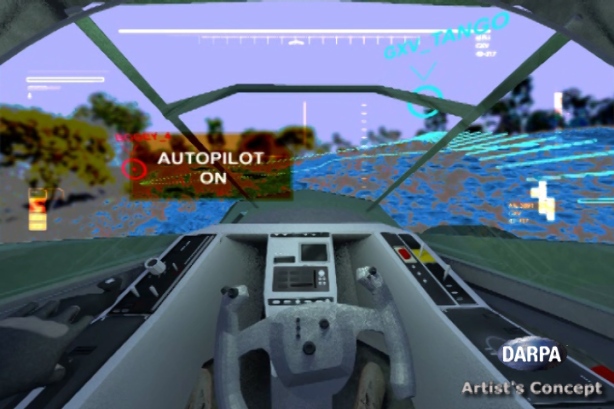

Un défi ambitieux qui a permis de développer un concept novateur : un véhicule agile, transformable, doté de toutes les technologies de navigation modernes, de LIDARs permettant de cartographier l’environnement, ou encore d’un cockpit mettant en œuvre des technologies de réalité augmentée permettant de tracer l’itinéraire le plus efficace d’un point de vue tactique, avec des pare-brise virtuels utilisant des caméras en lieu et place de vitrage.

Mais l’une des innovations les plus inattendues porte sur une technologie que chacun d’entre nous considère immuable – à tort – : la roue.

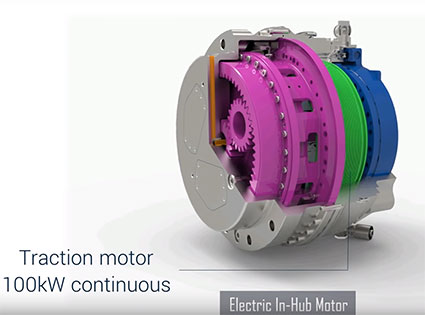

Outre des technologies finalement assez connues (l’idée de mettre par exemple le moteur à l’intérieur de la roue, un concept baptisé Electric In-Hub motor développé avec la société QinetiQ, mais connue par les constructeurs et équipementiers automobiles) le défi a permis de développer un nouveau concept : le MMES pour « Multi-mode Extreme Travel Suspension ».

Le concept est le suivant : la roue n’est plus un dispositif fixe, mais un système, qui s’adapte au terrain et à ses irrégularités. Le système MMES a pour objectif d’ajuster dynamiquement la hauteur et la forme de la roue en fonction du terrain.

Les roues MMES du véhicule concept GXV-T sont donc des roues adaptatives hydrauliques indépendantes, qui s’ajustent au relief du terrain afin de conserver une assise stable au véhicule. Voir la vidéo ci-dessous :

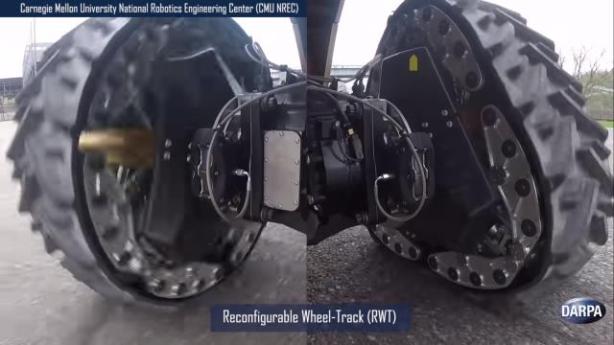

Mais un système concurrent, baptisé RWT pour Reconfigurable Wheel-Track, va plus loin. La roue devient un système robotisé muni de capteurs. Sur un terrain normalement praticable, rien à signaler : la roue est un cercle qui fonctionne de manière classique. Mais dès lors que le terrain devient irrégulier ou glissant, la roue devient triangulaire, fonctionnant à la manière d’une chenille (voir la vidéo ci-après) :

Et cela semble fonctionner sur la boue, la neige, ou les surfaces glissantes comme le gravier. Outre le caractère ingénieux de la chose, j’aime beaucoup cette innovation car elle montre bien que ce que l’on prend pour acquis (la roue) est quand même susceptible d’évoluer, de progresser, d’innover.

Le système a été développé par les cadors (sic) de la robotique, le Carnegie Mellon University National Robotics Engineering Center (CMU NREC). Et le concept fonctionne : il a été testé sur une base de véhicule HUMVEE au Maryland.

L’innovation, c’est un état d’esprit, et réinventer la roue en est indubitablement l’illustration…